KI kills again: leise, schnell und kostengünstig

Themen: Künstliche Intelligenz, Neues |Die Künstliche Intelligenz ist kein Sein, sondern ein Tun. Sie ist nicht beschränkt auf einen Bereich, weil sie jeden Bereich in seine Bestandteile zerlegen und analysieren kann. Darum sind wir aktuell auch schon weit über die bloße Generierung von Hausaufgaben und die Erstellung mehr oder weniger gelungener Fantasy-Artwork hinaus: KI gibt Therapiestunden, KI verrät Börsentipps, KI kennt Windows-Aktivierungscodes, KI generiert TV-Vorspänne.

Eher durch Zufall bin ich auf einen weiteren Bereich gestoßen, in dem die KI ordentlich aufräumen kann – sicher auch auf Kosten von Arbeitsplätzen.

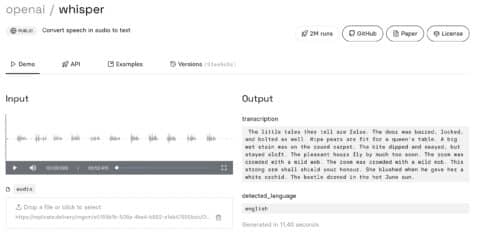

Für meine Fotostory zu DIE PINUPS UND EIN HEISSER TYP habe ich mir von Whisper.AI mal wieder die gesamte Tonspur transkribieren lassen, um Zitate nicht mühevoll händisch abtippen zu müssen. Weil ich dabei mein kostenloses Kontingent überschritten habe, bin ich nun zahlender Abonnent von Github-Rechenzeit. Ist nicht teuer, ist es mir außerdem wert.

Nun ist allein die Möglichkeit, einen Film komplett zu transkribieren, für z.B. Synchronstudios eine große Hilfe, wenn sie nicht gerade vom Studio ein Dialogbuch mitgeliefert bekommen. Der Transfer von Sprache in Text ist nicht perfekt, aber er macht die Drecksarbeit, die sonst Tage dauert, in ein paar Minuten. Dann braucht es – wie sonst auch – nur einen guten Lektor, der noch mal drüberschaut.

Das Problem: Whisper.AI wirft in den Standardeinstellungen nur einen unformatierten Block Text aus. Außerdem kann die KI (noch) nicht die Sprecher unterscheiden und entsprechend vermerken. Das ist bestenfalls Rohmaterial.

Also habe ich mal in die Einstellungen geschaut und bin auf zwei Parameter gestoßen, die Whisper.AI noch ganz andere Möglichkeiten verleihen.

Da ist zuerst einmal die automatische Übersetzung in andere Sprachen. Das bedeutet genau das, was ihr jetzt denkt: man wirft der KI z.B. eine Audiospur in englischer Sprache hin und sie kann Deutsch, Französisch, Italienisch etc. ausspucken. Erfahrungsgemäß schwankt die Übersetzungsqualität dabei je nach Input/Output-Sprache. Erneut gilt: nicht perfekt, aber ein solider Ausgangspunkt.

Damit kommen wir zu dem Parameter, der das Ausgabeformat bestimmt. Standardmäßig steht das Menü auf “plain text”, aber man kann auch die Formate .srt und .vtt wählen. Jeder, der sich mit aus dem Internet geladenen Filmen beschäftigt, kennt zumindest .srt. Das ist nämlich das übliche Format von Untertitelspuren, die vielen Video-Dateien separat beiliegen. Sie enthalten einen Zähler, eine exakte Zeitangabe, und den auf dem Bildschirm gesprochenen Text.

Besonders als Besucher von Events wie dem Fantasy Filmfest wird man immer wieder mit Untertiteln konfrontiert, die von hundsmiserabler Qualität sind – trotz menschlicher, händischer Arbeit. Ich habe schon Filme gesehen, bei denen die Untertitel das Geschehen nur vage oder widersprüchlich wiedergeben konnten.

KI kann auch DAS revolutionieren. Die KI kann die Tonspur des Films nämlich nicht nur transkribieren und übersetzen, sondern dann direkt in das Format wandeln, das für die Verwendung als Untertitel-Spur benötigt wird. Damit sind die drei großen Schritte der Untertitelung automatisiert.

Als Beispiel – so spuckt Whisper.AI eine Szene aus DIE PINUPS UND EIN HEISSER TYP im srt-Format aus:

179

00:09:31,900 –> 00:09:32,900

Du studierst? Wo?

180

00:09:33,900 –> 00:09:35,900

Ich gehe zweimal die Woche zur Abendschule. Und ich nehme Klavierunterricht.

181

00:09:36,900 –> 00:09:37,900

Oh, Günther.

182

00:09:38,900 –> 00:09:39,900

Pass auf, dein Kleid.

183

00:09:39,900 –> 00:09:40,900

Das ist doch jetzt egal.

Erstaunlich. Das ist fast ohne redaktionelle Nachbearbeitung verwendbar.

Zusätzlich beherrscht Whisper.AI auch das .vtt-Format, mit dem ich weniger vertraut bin und das wohl primär die Untertitel und die Metadaten von Web-Videos enthält. Darin werden auch Kapiteltitel und andere Beschreibungen festgehalten.

Diese Fähigkeiten von Whisper.AI ermöglichen es, mit extrem wenig Aufwand Untertitel-Spuren zu erstellen. Das ist natürlich erstmal für Firmen und Redakteure, die von der Erstellung solcher Untertitel leben, Segen und Fluch: Sie können auf die KI zurückgreifen, aber ihre Arbeit wird deutlich entwertet, weil praktische jeder Honk das auch kann. Es wird die Preise drücken.

Kleine Festivals und Filmverleiher werden davon profitieren, weil die Erstellung der Untertitel-Spur ein zu vernachlässigender Posten im Budget wird.

Der Kunde kann zumindest hoffen, dass auch bei kleineren Produktionen und Releases künftig bessere Untertitel beigelegt werden können.

Es gibt aber noch eine ganz andere Szene, die nun jauchzen wird: Die Fansub-Geeks. Fansubs sind von Fans erstellte Untertitel (subtitles), oft zu Anime-Serien, die mit einer offiziellen Untertitel-Spur nicht erhältlich sind. Deren Arbeit wird nun natürlich erheblich vereinfacht und beschleunigt.

Tatsächlich kann JEDER Filmfan, der über ein Video stolpert, dessen Sprache er nicht versteht, eigene Untertitel erstellen, um das Verständnis zu verbessern.

Der Ablauf:

- Film (wenn nicht schon passiert) in Videodatei umwandeln, z.B. mit der Freeware Handbrake.

- Tonspur trennen (mit vielen Freewareprogrammen möglich).

- Tonspur als MP3 bei Whisper.AI hochladen, Zielsprache und .srt-Format wählen.

- Generierte .srt-Datei mit gleichem Dateinamen in den Ordner des Originalvideos legen.

- Mit einem Untertitel-tauglichen Programm wie VLC abspielen.

Das sollte es schon gewesen sein. Die KI macht uns alle zu Experten.

Natürlich ist auch das ein “best case”-Szenario. Die KI ist nicht perfekt und auch bei DIE PINUPS UND EIN HEISSER TYP konnte sie viele Details nicht korrekt identifizieren. Aber sie ist gut genug, um als Ausgangspunkt zu dienen und viel nervige Tipperei zu ersparen. Das allein lohnt den Einsatz.

KI wird ja auch immer besser. So bekommt die neuste Version des Bildgenerators Stable Diffusion wohl das Problem der verkrüppelten Hände langsam in den Griff:

Ich kann keine moralische Wertung treffen: Ja, eine weitgehend automatische Generierung von Untertiteln entwertet und gefährdet Jobs, besonders von Freiberuflern. Aber sie demokratisiert auch, weil sie das Werkzeug vereinfacht und jedem zur Verfügung stellt. Untertitel brauchen kein Herrschaftswissen mehr.

Ein weiteres gemurmeltes “Alter Falter…” scheint angebracht.

Das ist übrigens auch für Hörgeschädigte super, da man sich dadurch auch Untertitel von Sachen anfertigen kann, für die bisher keine existieren. Sinkende Preise sorgen zudem hoffentlich auch für noch mehr Untertitelung.

Whisper.ai kannst Du übrigens auch lokal laufen lassen, da es Open Source ist.

Super, an die Hörgeschädigten hatte ich naturgemäß nicht gedacht. Lokal brauche ich das gar nicht, das Abo ist super billig.

übersetzen scheint whisper aber nur nach EN so wie es aussieht. dachte jetzt komme ich vielleicht doch noch an deutsche UTs für meine El internado laguna Negra Box 😉

Ja, die Bandbreite ist verbesserungsbedürftig.

Bischen getestet – ein französisches 4-Minuten-Snippet klappte ganz gut, bischen Nachjustierung bei Anzeigedauer und -beginn, aber im Prinzip tolles Ergebnis.

Eine italienische Komödie (90 min) hat durchwachsene Ergebnisse – am Anfang Nonsensübersetzungen (über Latein gestolpert?) und die Zeitangaben bei den Untertiteln sind teilweise perfekt, teilweise etliche Sekunden zu früh, so dass der Dialog als UT fast vorbei ist, wenn der gesprochene Dialog gerade beginnt.

Ikuru von Kurosawa (100 min) sah eigentlich nicht schlecht aus – ausser dass die zweite Hälfte nur noch “-” als Texte enthält, die Anfänge sahen aber (nach DeepL-Durchlauf) recht gut aus.

Sehr spannend – toll, dass du das so ausführlich getestet hast. Bei mir war es so, dass Whisper nach einem englischen Musikstück den Rest des Skripts auf einmal automatisch auf Englisch übersetzt hat. Und am Ende kam statt Musik nur noch 200 mal “bob bob bob”.

Kommt halt stark auf die Sprache an. Deutsch, französisch und spanisch zu English sollte an sich recht gut sein, weil es genug Material zum trainieren gibt. Bei Italienisch wirds schon schwerer. Und solch semantisch verschiedene Sprachen wie Chinesisch/Japanisch und Englisch brauchen ein noch viel viel mehr Daten zum Trainieren.

Exakt so ist das.

Habe Abo für die Software von Adobe. Das Schnittprogramm ADOBE PREMIERE kommt mit ‘nem Zugang zu so’ner Speech-to-text-Funktion. Wenn ich was transkribiert haben möchte, lege ich ein neues Videoprojekt an. Ohne Videospur. Nur mit Tonspur. Und dann lass ich das Programm ein Transkript erstellen. Same thing. Spart so viel Zeit. Interviewtranskripte usw.

Deepl ist mein Go-To-Übersetzer im zweiten Schritt.

Absolut. Aber es würde die Sache nochmal vereinfachen, wenn die Transkribierung mit der Übersetzung kombiniert werden könnte.

Ich bin eigentlich ganz zu frieden mit der übersetzung von meinem text ins deutsche mit chatgpt. aber ja, bei großen artikeln wirds manchmal komisch, aber 1000x besser als google translate allemal.