Dall-E 2: Mein erster Tag mit der Digitalkunst-Revolution

Themen: Künstliche Intelligenz, Neues |Ich habe in den letzten Monaten immer mal wieder über KI-kreierte Kunstwerke gesprochen. Das ging von rudimentären Ansätzen wie bei Wombo bis zu komplexen “text to picture”-Systemen wie MidJourney. Die Ergebnisse faszinieren, sind aber momentan noch mehr Experiment als Ersatz für echtes Grafikdesign.

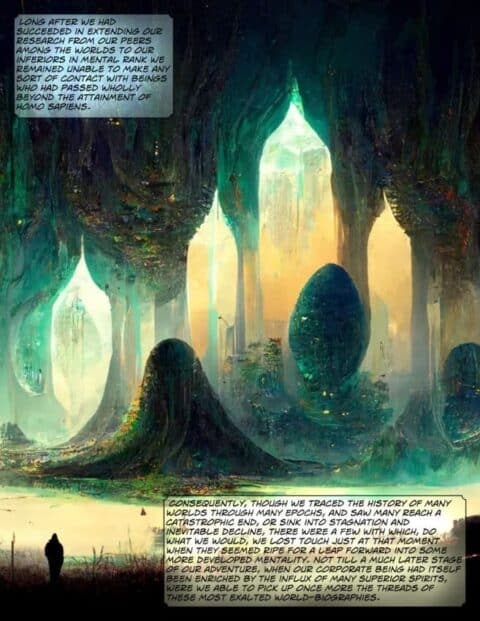

Nun entwickelt sich die KI-Grafik mit einer Geschwindigkeit, die schwindelig macht. Demnächst erscheint ein Roman von Olaf Stapledon in einer illustrierten Fassung. 700 vierfarbige Zeichnungen, kreiert von MidJourney und in 100 Stunden zu einer Art Graphic Novel verarbeitet. Das bedeutet: eine Illustration pro 8 Minuten.

Machen wir uns nichts vor: Jeder Kritiker, der von der KI-Genese nichts weiß, würde das hier als “üppig und liebevoll illustriert” bezeichnen:

Man muss das auch nur mal weiterdenken: Was ist, wenn man nicht mal mehr die Grafiken selber generieren muss, sondern der KI nur noch den Text des Romans füttert, damit diese zu den relevanten Stellen eigenständig die Illustrationen generiert? Kann die KI für einen Regisseur aus dem Drehbuch die Storyboards erstellen?

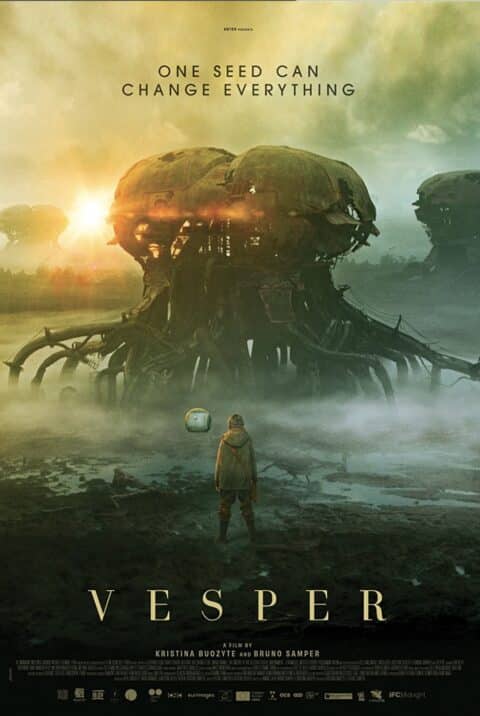

Bei solchen Filmpostern ist kaum auszumachen, ob da ein Grafiker oder eine KI dran gesessen hat:

Und das ist erst der Anfang. Es gibt Herausforderer, die MidJouney den Platz als “hot shit of the moment” streitig machen wollen. Bei Dall-E 2 hatte ich mich vor Monaten angemeldet, aber immer noch keinen Zugang erhalten. Das hat sich seit gestern geändert – Dall-E 2 ist nun offen für alle, die einen Account wünschen.

Über die Hintergründe will ich hier gar nicht groß schreiben, das könnt ihr z.B. beim SPIEGEL nachlesen. Mir geht es eher darum, euch meine ersten konkreten Erfahrungen mit der Engine zu illustrieren.

Zuerst einmal: wow. Dall-E 2 ist ein “game changer”, und ich verwende den Begriff wahrlich nicht leichtfertig. Die KI ist nicht nur leichter zu bedienen als MidJourney, sondern auch erheblich leistungsfähiger. Dall-E 2 kann praktisch jeden Stil und jede Technik simulieren, 3D rendern oder Fotos nachahmen. Der Algorithmus kann sogar Bilder um fehlende Teile ergänzen. Bedenkt man, dass das erst der Anfang der Entwicklung ist, dann dürfen wir spannende Jahre erwarten.

Gleich zu Anfang mal ein Beispiel, wie groß der Abstand zwischen MidJourney und Dall-E 2 jetzt schon ist. MidJourney scheitert beim Versuch, einen Erdbeerkuchen auf einem Teller realistisch darzustellen, weil es irgendwie den Begriff “Erdbeere” etwas eigenwillig interpretiert:

Dall-E 2 hat hingegen kein Problem, das fotorealistisch umzusetzen:

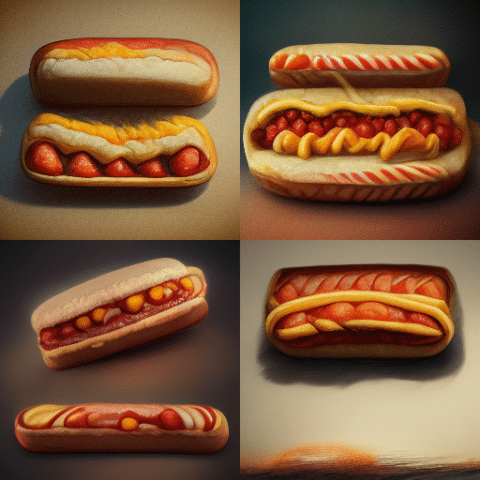

Nehmen wir den schnöden Hot Dog – sollte ja wahrlich kein komplexes Problem sein, oder? Leider scheint MidJourney zwar die Bestandteile des Hot Dogs zu verstehen, nicht aber deren Anordnung zueinander:

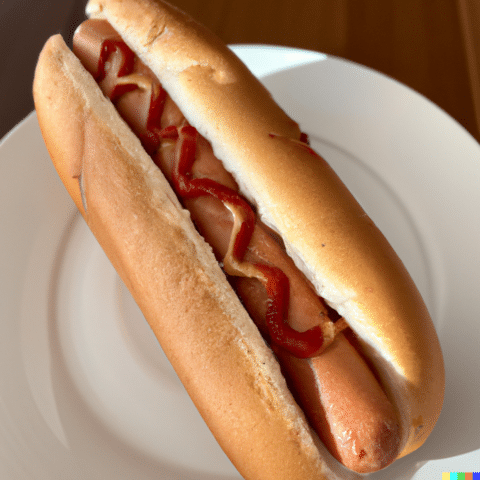

Mal eben fix “photo of a hot dog on a plate” bei Dall-E eingeben:

Das ist praktisch nicht mehr von einem Foto zu unterscheiden.

Schauen wir uns kurz die Outpainting-Funktion an, die Bilder um fehlende Teile ergänzt. Ich suche ganz banal ein Bild unserer jungen Katzen raus:

Ich bitte Dall-E 2, das Bild auf der linken Seite weiter zu rechnen. Ergebnis:

Fucking hell!

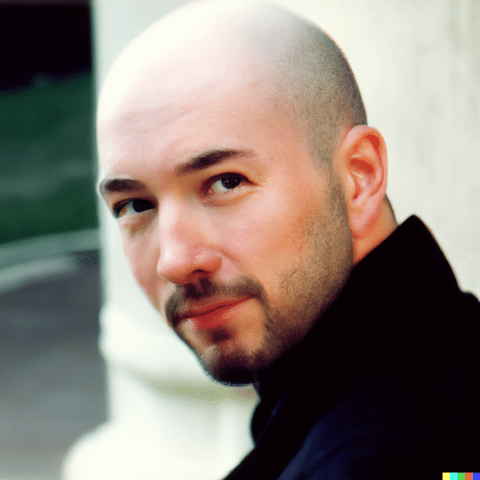

Dall-E 2 kann vorgegebene Bilder auch erschreckend gut manipulieren – das hier war die Grundlage meines allerersten Blog-Logos:

Wenn ich Dall-E 2 instruiere, mir davon Variationen zu erstellen, dann ist das Ergebnis sehr ähnlich – aber das bin ja eindeutig nicht mehr ich:

Weiter im Text – “key lime pie on a plate with lemonade in a garden”:

Leserin Silke hatte zu diesem Bild auf Facebook eine interessante Frage: “Wo ist das Rezept?”. Dall-E 2 produziert Speisen ohne Zutaten, und folglich ohne Rezept.

Lieber was Herzhaftes? “schnitzel viennese style on a plate in a restaurant”:

Ich sehe ganz düstere Zeiten für Food- und Deko-Fotografen aufziehen…

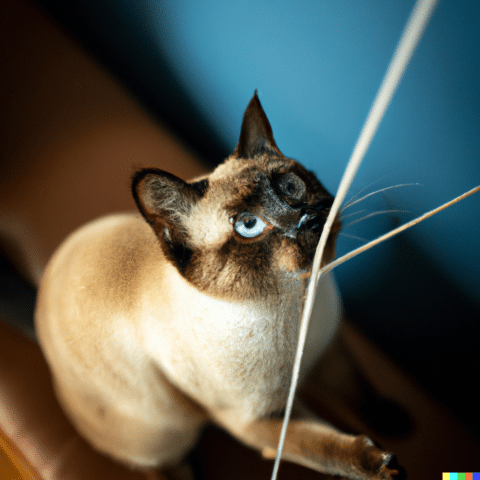

Diese spielende Katze ist keine Katze, nie eine gewesen:

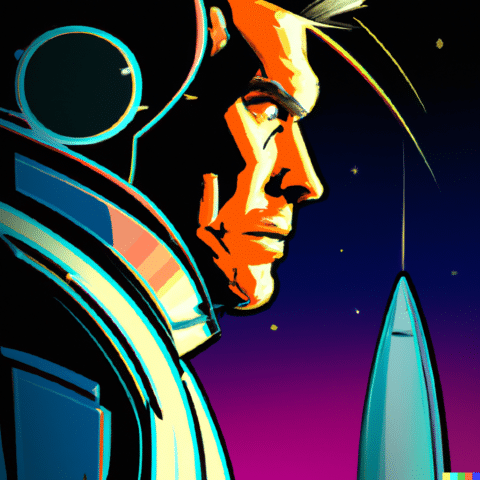

Nun ist Fotorealismus die eine Sache – Kunst eine andere. Dall-E 2 kann die holländischen Alten Meister ebenso imitieren wie Picasso, Propaganda-Plakate, Comics, Bleistift, und sogar den Look des Musikgenres Synthwave. Ich gebe “Rocketeer, synthwave style” ein:

Ehrlich? Ich möchte es auf A0 ausdrucken und bei mir an die Wand hängen.

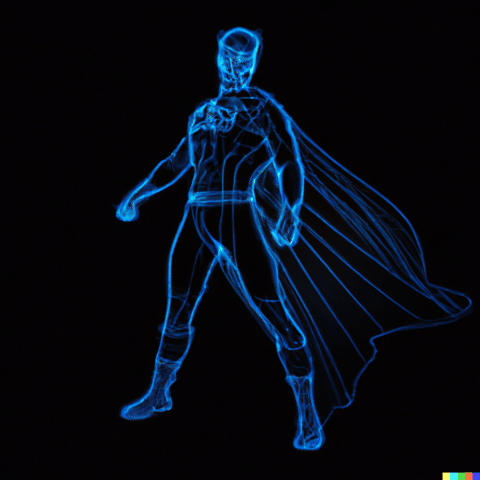

“rendering of superhero as a 3d wireframe graphic” bringt genau das, was ich wollte:

Eine Weltraumschlacht zu visualisieren ist schwierig, weil Dall-E 2 relativ genaue Angaben braucht, um das zu produzieren, was ich vor meinem geistigen Auge sehe – aber einer gewissen brachialen Dynamik mangelt es nicht:

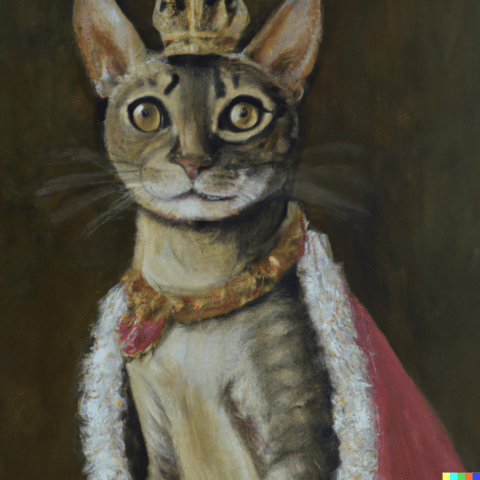

Versuchen wir uns mal an einer Kopie dieser “Gemälde”, auf denen Haustiere wie Adelige rausgeputzt sind – “oil painting of a cat with a crown and royal robe, 18th century style”:

Um zu zeigen, wie weit man das treiben kann: Jemand hat Dall-E aufgefordert, Johannes Vermeers berühmtes Gemälde “Mädchen mit Perlenohrring” stilecht nachzuahmen – aber mit einem Otter:

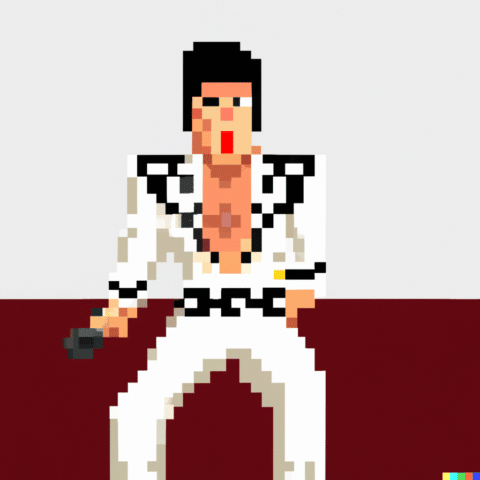

Wer es abstrakter mag – Elvis als “pixel art”:

Wie wäre es mit einer stilisierten Illustration der Skyline meiner Heimatstadt Düsseldorf, bewusst reduziert gehalten?

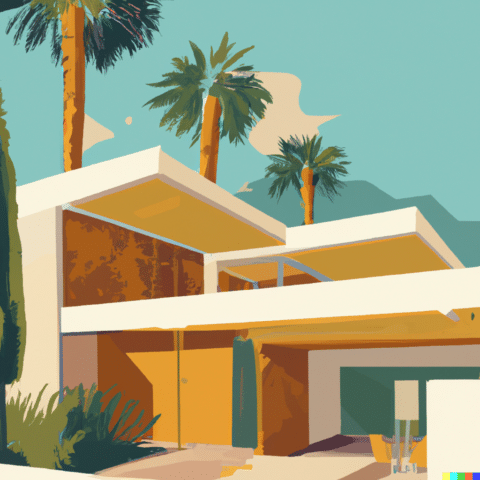

Es reizt mich immer, Palm Springs zu visualisieren – eine Stadt, die unseren Einrichtungsstil mit geprägt hat. Zuerst anhand der Architektur: “Illustration of midcentury architecture in a Palm Springs setting, 60s illustration style”:

Man könnte das im Laden verkaufen. Ich denke ernsthaft darüber nach, daraus eine Serie mit 12 Motiven für unser Schlafzimmer zu produzieren.

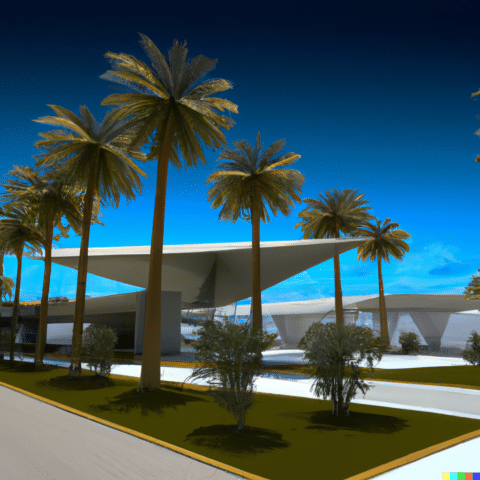

Nächster Test: ähnliche Vorgaben, aber mit der Bitte, es mal in 3D zu rendern. Das Ergebnis ist mir allerdings etwas zu spartanisch und simpel:

Kann man sich auch Logos für Geschäftsideen generieren lassen? Ich bitte Dall-E 2, mir Vorschläge für ein Cartoon-Logo eines Katzensitter-Services zu machen:

Hätte es die Software vor 16 Jahren gegeben, hätte ich das Logo für mein Blog vermutlich damals schon von Dalle-E 2 entwerfen lassen:

Nicht perfekt. aber ich würde in Photoshop vielleicht zehn entspannte Minuten brauchen, um es perfekt zu machen.

Damit kommen wir zu den (durchaus reparierbaren) Problemen von Dall-E 2.

Wann immer Dall-E 2 eine Person oder ein Tier realistisch abbilden soll, wird es – wie bei MidJourney – ein Schuss ins Blaue. Die Extremitäten und Details (Hände, Finger, Ohren) sind oft komplett daneben, bei den Proportionen hapert es, besonders mit Augen tut sich der Algorithmus sichtlich schwer – als mangele es die Erkenntnis, dass Augenpaare üblicherweise gleich aussehen und in dieselbe Richtung schauen.

Ein gutes Beispiel dafür generiert die Eingabe “müder Autor an einem unaufgeräumten Schreibtisch im Stil von Norman Rockwell”:

Das Ergebnis ist so lange beeindruckend, bis man genauer hinschaut:

Da würden dann auch meine Photoshop-Skillz erstmal versagen…

Bei der weiblichen Variante hat es etwas besser geklappt:

Zu einem weiteren Experiment wurde ich durch dieses Prospektfoto von LIDL inspiriert – ein Herbstmotiv, wie wir es auch in der Liebes Land verwenden:

Geht sowas auch per KI? Ich gebe “photo of a little girl picking flowers in a garden during autumn, moody lighting” ein:

Wieder etwas monströs in den Details, aber wieder auf einem guten Weg.

Ich weiß, die Grafiker unter meinen Lesern werden sich mit Grauen abwenden, aber ich fürchte, ein relativer lukrativer Job wird es in den nächsten Jahren sein, von KI gefertigte Entwürfe nur noch zu “fixen”, also die offensichtlichen Fehler zu retuschieren. Der Künstler als Handlanger der Maschine – keine schöne Vorstellung, aber auch nicht (mehr) weit hergeholt.

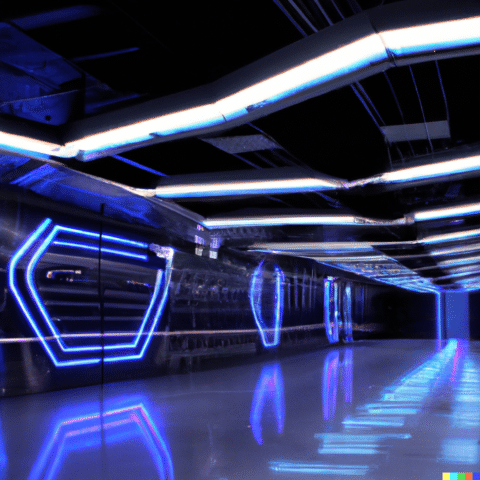

Gut möglich, dass auch Architekten, Bühnenbauer und Spieledesigner sich künftig massiv von der KI inspirieren lassen. Du brauchst eine futuristische Ubahn-Station im Neonlicht? Dall-E 2 stellt sich das so vor:

Da könnte man als Autor sogar wieder den Weg zurück gehen: Die Grafiken von Dall-E 2 dienen als Vorlage, wie man Szenerien in einem Roman beschreibt.

Es gibt allerdings erstaunlich einfache Motive, an denen sich Dall-E 2 im direkten Vergleich zu MidJourney überhebt. Für ein künftiges Projekt habe ich MidJourney gebeten, mir ein realistisches Porträt eines Zombies zu generieren. Mit dem Ergebnis bin ich sehr zufrieden:

Dall-E 2 hingegen scheint die Vorgabe eher für einen Scherz zu halten:

Interessant auch, was Dall-E 2 unter dem “perfekten Motorradhelm” versteht:

Da ist die Version von MidJourney deutlich interessanter:

Man sieht: Die Phantasie des Users ist in den meisten Fällen begrenzter als die Möglichkeiten der Software. Es lohnt sich immer, auch mal in Galerien nach den Experimenten anderer Nutzer zu schauen, um sich inspirieren zu lassen.

Immer noch nicht gelöst scheint die Rechtsfrage zu sein – wem gehören die generierten Artworks? Es wäre mir relativ wurscht, wenn andere Leute meine Motive “klauen” würden, solange ich dafür das Recht habe, sie frei für eigene Projekte zu verwenden. Das wird sicher in den nächsten Monaten zu klären sein.

Machen wir uns nichts vor: Es ist eine Zeitenwende – und sie kommt schneller und stärker, als wir alle gedacht hatten. Der Computer wird “kreativ” – und das “kreativ” werden wir in absehbarer Zeit nicht mehr Anführungszeichen schreiben müssen. Sollte man KI-generierte Artworks eigentlich verpflichtend kennzeichnen müssen?

Was ich mir noch wünschen würde? Der Algorithmus muss lernen, wie Menschen und Tiere proportioniert sind, die Stimmigkeit der Figuren darf nicht mehr reiner Zufall sein. Und wenn ein Bild einen spezifischen Stil hat, sollte man diesen als Grundlage für weitere Illustrationen kopieren können, um z.B. fortlaufende Geschichten zu erzählen. Dazu gehört, Teile eines Bildes zu “freezen” und nur bestimmte Bereiche mit neuen Inhalten zu füllen. Damit wäre viel gewonnen.

Was kostet der Spaß? Anfänglich nichts, sowohl MidJourney als auch Dall-E 2 geben Einsteigern ein paar “credits”. Auch danach finde ich die Preisgestaltung fair: das Basic-Abo von MidJourney kostet 11,90 Dollar im Monat und erlaubt 200 Nutzungen. Bei Dall-E 2 werden für 115 Credits 17,85 Dollar fällig. In meinen Augen ist es das absolut wert.

Wie seht ihr das – beeindruckend, erschreckend, oder ein alberner Hype, von dem in drei Monaten kein Mensch mehr redet? Habt ihr Ideen, was ihr mit Dall-E 2 machen würdet? Was die Software noch können sollte/müsste?

Und an die Grafiker da draußen: Muffensausen?

Wie werden die ursprünglichen Gestalter beteiligt, mit deren Bilder die Maschine geschult wurde? Sollte erst kommerziell verwendet werden wenn das geklärt ist.

In den Details sehr oft verstörende Perspektivfehler, vgl. „unmögliche Figur“ https://de.m.wikipedia.org/wiki/Unm%C3%B6gliche_Figur

Meines Wissens nach wird die AI nicht mit bestimmten Bilder von Gestaltern geschult, sondern mit einer generellen Masse an Material. Und da die AI keine Elemente der Vorlagen direkt übernimmt, gibt es keine direkte Notwendigkeit, jemanden zu beteiligen. Ich sehe da auch keinen Bedarf einer Klärung.

Sowas müsste doch auch im echten Leben mit einem Grafiker / Illustrator geklärt werden – Bezug nehmend auch auf Torstens Antwort und der Phrase ‘generelle Masse an Material’:

Welche Bilder und Eindrücke hat der Grafiker / Illustrator in seinem Leben bisher gesammelt um ein Bild zu zeichnen? Da werden auch keine Copyright-Fragen gestellt, außer derjenige kopiert.

Nichts anderes passiert mit der KI, die mit Bildern und Eindrücken gefüttert wird.

Exakt.

Zwischen der Verarbeitung von Eindrücken und Erfahrungen durch den Menschen und eine KI gibt es noch gravierende Unterschiede, da sollte schon differenziert werden. Meines Wissens werden zudem auch durchaus bestimmte Werke bestimmter Künstler zum Anlernen genutzt, wenn es darum geht, spezifische Stile zu imitieren. Denke allerdings auch, dass da rechtlich nichts zu machen sein wird.

So macht es der Mensch ja auch. Wenn ich malen möchte wie van Gogh, dann schaue ich mir Bilder von van Gogh an. Und genau wie der .. gewissenhafte .. Mensch fängt auch die KI nicht an, da größere Teile rauszuschneiden und in eigene Werke einzubauen, sondern erlernt den Stil. Da ist der facto kein klar definierbarer Unterschied.

Bei den spezifischen Werken geht es ja nicht um den Unterschied zwischen KI und Mensch. Dieser liegt in der Art und Weise des Lernens.

wie man etwas lernt ist doch bei menschen auch unterschiedlich. von mir aus kannste noch tiere mit dazu zählen, die wieder noch andere lernformen, auch innerhalb der eigenen art, haben. die ki ist nur eine weitere art mit weiteren eigenen lernformen

die hirnforschung guckt sich ja nicht umsonst alle möglichen gehirne an – gerne die von genies – und wie die gebaut sind. da sind allein schon wegen der unterschiedlichen ausprägungen / bauarten der gehirne innerhalb einer spezies verschiedene lernformen drin

Zum Erdbeer-Bild: ich finde das Midjourney-Bild nicht komplett verkehrt. So sehen die Erdbeeren aus dem Garten meiner Oma auch meistens aus.

Ansonsten scheint es nur noch ein Mini-Schritt zu sein, bis auch Menschen okayisch aussehen – das macht mir Angst, im Hinblick auf Missbrauch. Aber das ist nicht der erste und wird nicht der letzte sein… 🙁

Es geht mit bei dem MidJourney-Bild weniger um die Erdbeeren auf dem Teller – der Kuchen sieht halt komplett daneben aus.

ja, das stimmt. der kuchen sieht komisch aus.

Hier ein Video was zeigt was die Jungs von Corridor Digital mit KI anstellen können https://youtu.be/W4Mcuh38wyM

Alder, das überspringt ja schon wieder zwei Stufen…

Wow!

Mir als Fotograf ist seit Wochen schlecht wegen dem Thema. Ich sehe es schnell kommen das z.B. Werbeagenturen oder Werbeabteilungen in großen Firmen einen Artdirektor haben der schlicht mit einer KI Arbeitet. Das wird unser Berufsfeld massiv einschränken.

Mmn sehen wir hier, wie viele Tausend (oder weltweit Millionen?) Jobs in den Bereichen Foto/Fotoassistenz, Grafik, Text, Übersetzung, Synchronsprecher und mittelfristig auch Film zu Gunsten einiger weniger Tech Firmen in den USA Hops gehen.

Zum Thema füttern mit Bildern: die KIs werden schon auch spezifisch trainiert einen speziellen Künstler zu imitieren, da werden teilweise sogar Bruchstücke des Wasserzeichens reproduziert. Das ist zwar kein klassisches Copyright Problem aber die Frage stellt sich schon ob man da nicht wenigstens versuchen sollte mit Rechtsmitteln anzusetzen. Auch wenn ich mir da wenig Hoffnung mache.

Atemberaubend. “Muffensausen” hab ich noch keine, weil ich persönlich kein reiner Illustrator bin, aber klar, ich sehe durchaus die Gefahr für die Branche. Bin gespannt, wie das alles in zwei, drei Jahren aussieht.

Ich werde mich mit den Tools auf jeden Fall auch beschäftigen, ich sehe da tolle Möglichkeiten, Illustrationen per AI anzulegen und sie dann zu bearbeiten. Das ist das gute an meinem Job: Ich hab die Photoshop-Skills.

Darauf komme ich vielleicht noch zurück 😉

“Dazu gehört, Teile eines Bildes zu “freezen” und nur bestimmte Bereiche mit neuen Inhalten zu füllen”

In-painting kann Dalle aber schon lange. Den Edit-Modus benutzen, Teil des Bildes löschen, Beschreibungstext dazu und die Lücke wird wieder gefüllt und darin ist Dalle verdammt gut.

Der Zombie ist sehr typisch. Wenn die Bildinhalte phantastischer oder kreativer werden sollen geht bei Dalle nicht mehr viel und man plagt sich mit ziemlichem Murks herum. Dafür finde ich Midjourney wesentlich spannender.

Wow, wirklich beeindruckend. Aber denken wir mal weiter: In ein paar Jahren wird man ganze Filme so drehen können. Rein KI-basiert. Du fütterst als Autor nur noch paar Zeilen in die KI und die spuckt dir den Film samt (fotorealistischer) CGI aus. Einfach nur unglaublich.

Könnte für seichte Liebesfilme oder Actionware nach Schema F sogar halbwegs funktionieren, aber Humor, Subtilitäten, Überraschungen, intensive Emotionen – da habe ich massive Zweifel. Gibt schon jetzt genug Menschen-gemachte Filme und Serien, die an sich toll aussehen, aber mich sowas von kalt lassen…

Das sehe ich ähnlich – Geschichten erzählen lebt von Nuancen, die ein Computer nicht einfach kalkulieren kann. Vielleicht wird es aber eine neue Art von “filmischem Erlebnis” geben, das dem Computer mehr in die Hände spielt.

Die Zeilen eines Liedes einzeln als Bild interpretieren zu lassen ist teilweise SEHR verstörend, obwohl das Lied selbst es absolut nicht ist.

https://www.youtube.com/watch?v=KZEsCldqTt8