MidJourney: Tod oder Durchbruch moderner Gebrauchsgrafik?

Themen: Künstliche Intelligenz, Neues |Über Wombo.art hatte ich ja bereits ausführlich geschrieben. Die KI dieser Software generiert aus Stichworten teils faszinierende, meist aber sehr vage Artwork, die mehr von der Stimmung und der Atmosphäre lebt als von dem, was sie tatsächlich zeigt. Während ich das sehr wegweisend finde, widersprachen diverse Leser lautstark.

Seit ein paar Wochen sind KI-Algorithmen im Netz verfügbar, die noch mal eine deutliche Schippe drauflegen – und deren mögliche Auswirkungen man durchaus langsam mal diskutieren muss. Shit is getting serious.

Es lässt sich schwer leugnen: Hier wachsen mächtige Werkzeuge, nicht nur für den Bereich Buch-Cover und Poster – der gesamte Bereich der Gebrauchsgrafik steht vor einem Umbruch, wenn man der KI einfach nur ein paar Stichworte hinschmeißen muss, damit sie daraus professionell wirkende Illustrationen nahezu jeden Stils liefern kann.

Der “hot shit of the day” ist dabei MidJourney, eine KI, die über einen Discord-Kanal gefüttert wird. Kennt man sich mit dem Thema gar nicht aus, klingt das erstmal verwirrend, aber letztlich ist es vergleichsweise einfach:

Ich bin heute auf das Thema gekommen, weil Autor und Grafiker Michael Marrak es auf Facebook ansprach. Er ist durchaus betroffen: wenn Autoren überzeugende Cover ihrer Bücher selber gestalten können, werden Grafiker dafür obsolet.

Ist das noch Zukunftsmusik oder eine Realität, die nur noch nicht akzeptiert wird?

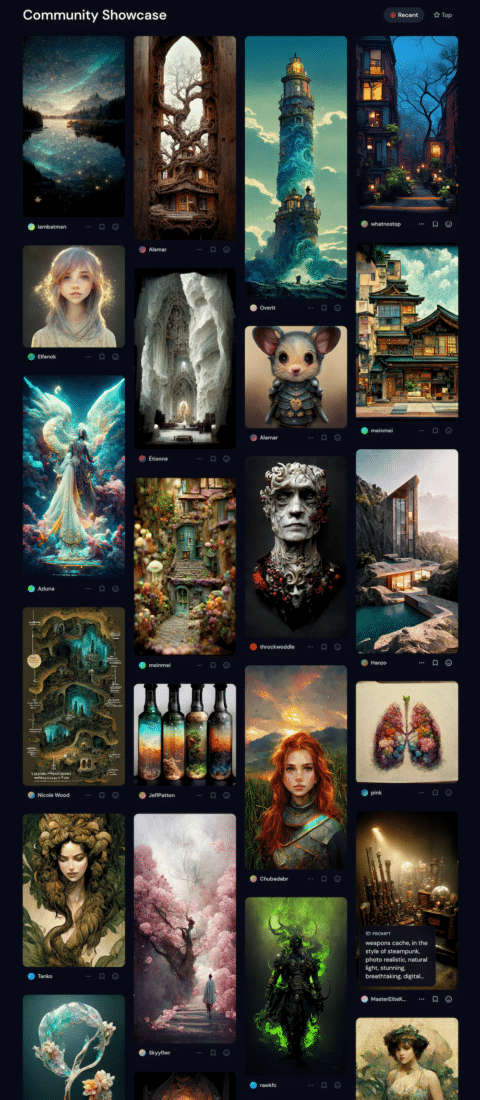

Richtig wegballern lassen könnt ihr euch erstmal auf der Showcase-Seite von MidJourney, wo besonders prächtige Kreationen ausgestellt werden. Klickt man auf die Bilder, erfährt man sogar, nach welchen Stichworten sie erstellt wurden.

Um es noch mal klar zu sagen: Das sind keine Collagen aus Internet-Quellen, keine “mashups” – das hier sind von der KI in 60 Sekunden kreierte Originale.

Die Tatsache, dass sich MidJourney als offene Community versteht, hat Vor- und Nachteile, wenn ich das richtig verstanden habe: man darf die generierten Bilder tatsächlich verwenden – mit geringen Einschränkungen auch kommerziell -, aber sie gehen nicht ins Eigentum dessen über, der sie generiert hat. Alles gehört allen.

Die ersten Gehversuche kann man kostenlos machen, danach ist ein Abo nötig, das ich absolut fair bepreist finde: 10 Dollar im Monat für 200 Anfragen an die KI.

Es gehört allerdings ein wenig Übung dazu, ausdrucksstarke Grafiken zu erstellen. Mein Einstieg in MidJourney war gestern eher holperig. Trotzdem beeindrucken mich die Ergebnisse und ich möchte sie mit euch teilen.

Vielleicht erinnert sich der eine oder andere Wortvogel-Veteran, dass ich mal ein paar Nibelungen-Romane geschrieben habe und von den Artworks sehr beeindruckt bin, auch wenn sie “nur” digitaler Natur sind. Da lag es nahe, MidJourney erstmal mit “barbarischer Krieger bekämpft Drachen im Stil eines Gemäldes” zu füttern.

Leider vertippte ich mich, machte aus dem Krieger einen Plural und die Drachen sind natürlich auch nicht mengenmäßig festgelegt. Dennoch:

Das ist schon ziemlich feist, dynamisch und atmosphärisch. Es hilft, dass man die KI bitten kann, einige der vier Vorschläge nochmal als Grundlage für vier weitere Vorschläge zu nehmen. Und den Favoriten kann man dann in ordentliche Auflösung hochrechnen (maximal 1664 x 1664 Pixel). Diese ist zwar streng genommen noch nicht druckreif, aber Programme wie Pixelmator Pro nutzen ebenfalls KI, um das ordentlich zu skalieren.

MidJourney hat aber teils sehr kuriose Beschränkungen – ich wollte das Bild eines “verführerischen Marilyn Monroe-Typs durch die Wolken treibend” generieren und musste mich belehren lassen, dass “verführerisch” ein gesperrter Begriff ist und die Verwendung von gesperrten Begriffen zu einer Sperre des Nutzers führen kann. Man scheint sich Regel 34 um jeden Preis widersetzen zu wollen.

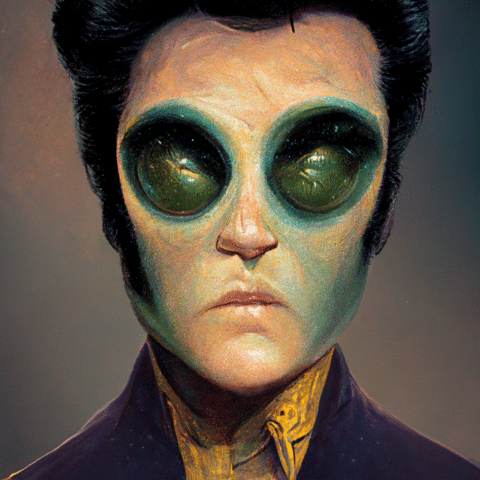

Meine nächste Idee: Ein bizarres, verstörendes Motiv, bei dem ich MidJourney viel Raum lasse: “Elvis Presley als Alien”. Hätte ich vor, eine Satire über einen Außerirdischen zu schreiben, der auf der Erde als Rock’n’Roll-Musiker Karriere macht, dann wäre das hier allemal ein exzellentes Cover dafür:

Wildern wir noch ein wenig im Territorium der Herren Marrak, Thiemeyer und Eckartsberg: angenommen, ich möchte einen Roman im zerstörten und von der Natur zurück eroberten Manhattan spielen lassen. Wie würde MidJourney das illustrieren? Die Antwort der KI:

Wer jetzt einwirft “da sind ja gar keine Personen zu sehen” – das stimmt. Aber im Gegensatz zu Wombo nur deshalb, weil ich MidJourney nicht darum gebeten habe.

Nun sieht das alles aus wie Ölgemälde und dieser Stil ist ja wahrlich nicht für jedes Projekt passend. MidJourney kann auch anders. Die Bitte, lachende Teddybären mit dem Attribut “realistisch” zu generieren, kann Alpträume auslösen:

Natürlich sind das alles erstmal nur Spielereien ohne echten Wert. Was könnte ich wirklich mit so einer KI anfangen? Nächstes Experiment. Ich habe vor Jahren an einem belletristischen Gruselroman mit dem Titel “Ein Ticket für den Totenzug” gearbeitet, in dem spät nachts in London eine U-Bahn auftaucht, die von Skeletten und Dämonen gesteuert wird und Menschen in die Hölle holt (eine Hommage an “Der Zug zur Hölle”, eine meiner Liebligsgeschichten von Robert Bloch).

Also schnell mal “alte Londoner U-Bahn in der Station, bevölkert von Skeletten und Dämonen” in die Command-Zeile getippt. Ergebnis:

Für einen “Gespensterkrimi” wäre das nicht nur völlig in Ordnung, sondern Meilen besser als das, was die Verlage aktuell auffahren.

Wer es futuristisch mag und eher auf Science Fiction als auf Horror steht – wie wäre es mit einem bewaffneten Cyborg-Ninja in einer Synthwave-Metropole?

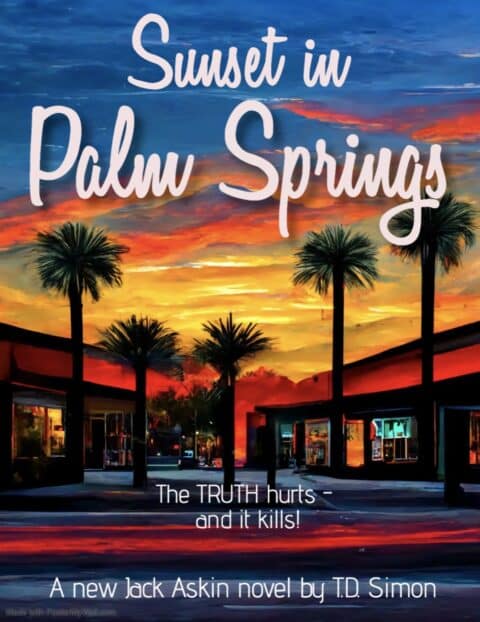

Da wir unsere Wohnung im MidCentury/Palm Springs-Stil eingerichtet haben und noch nach ein wenig passender Artwork suchen, tippe ich “Downtown Palm Springs bei Sonnenuntergang in kräftigen Farben ein”:

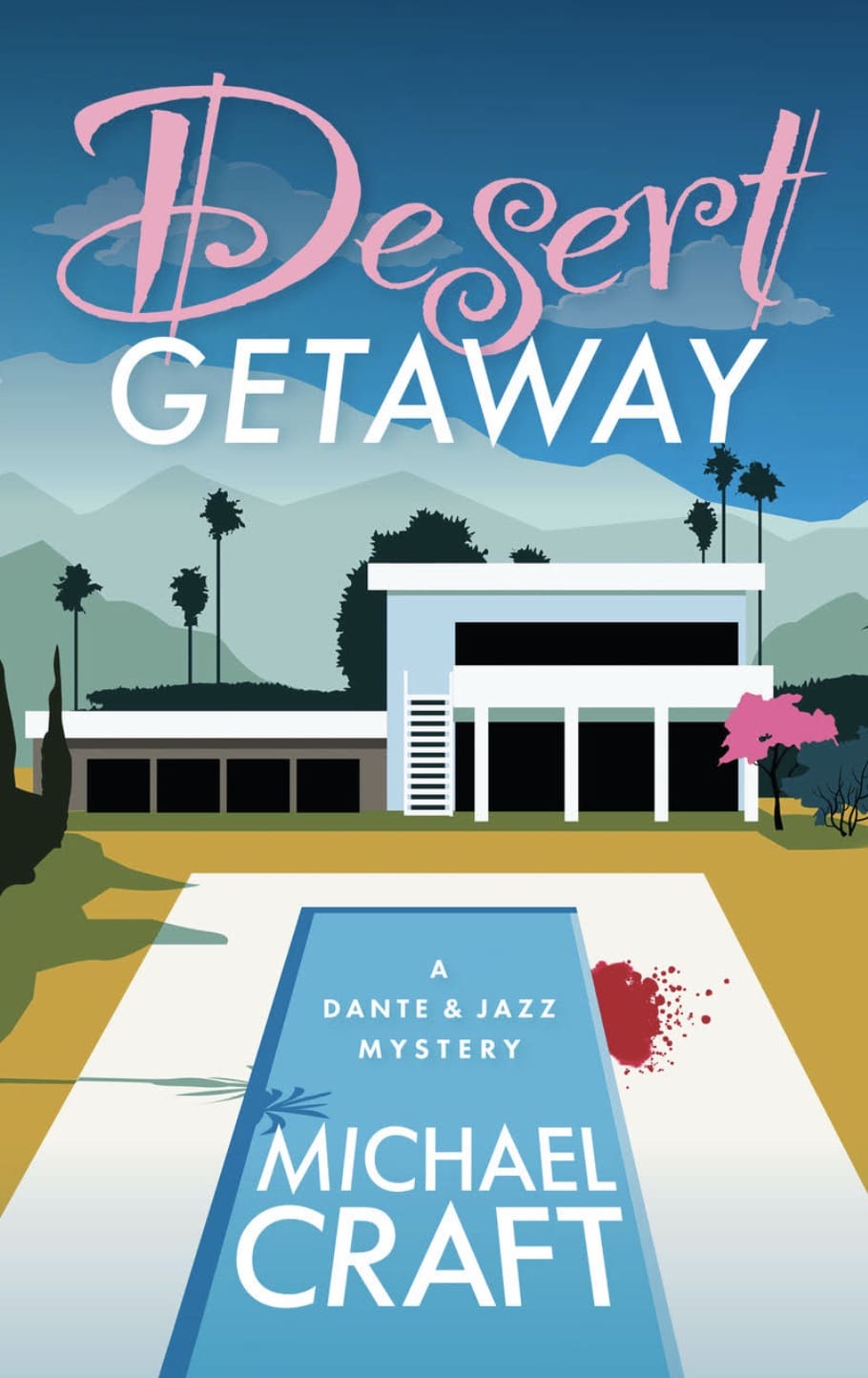

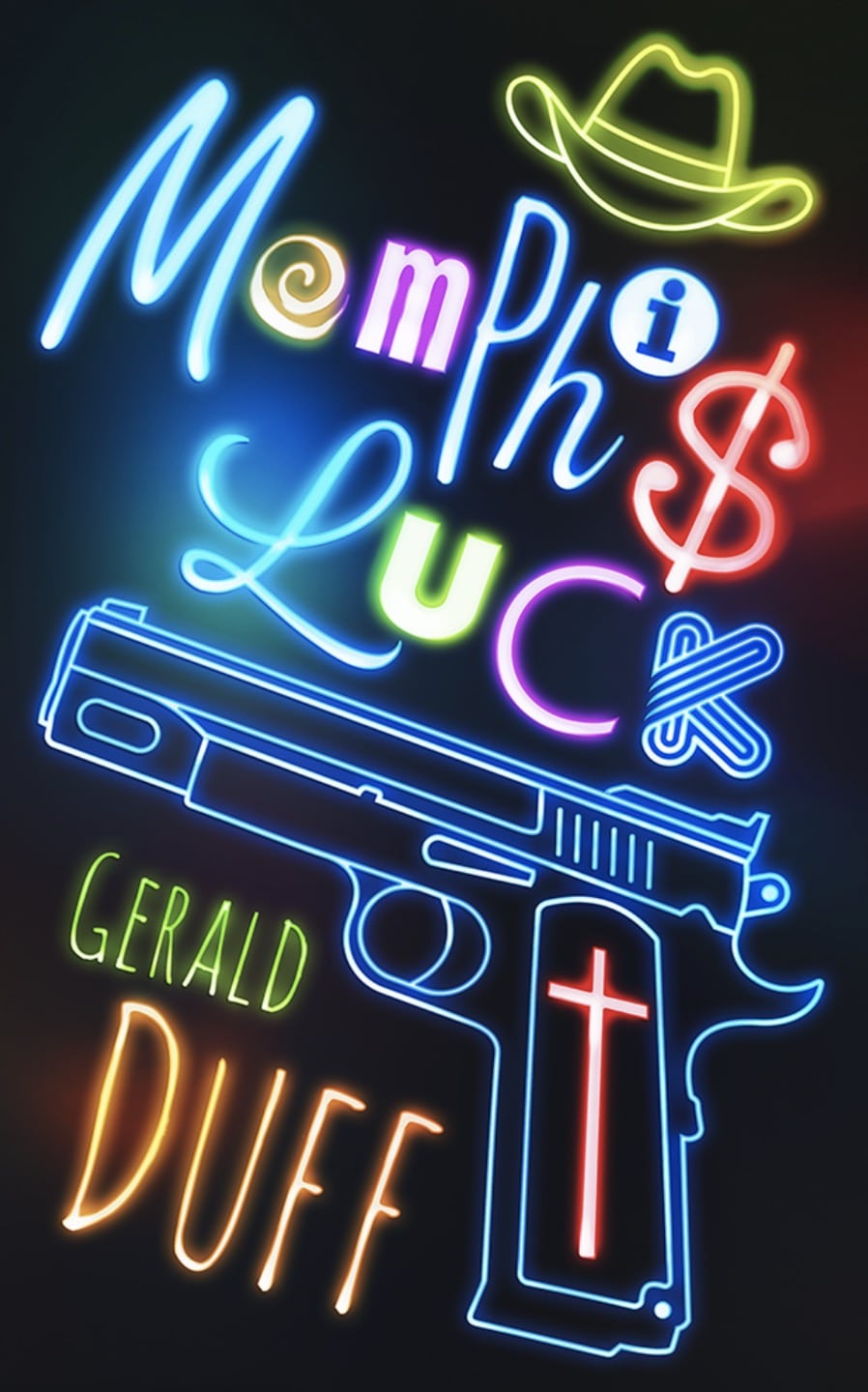

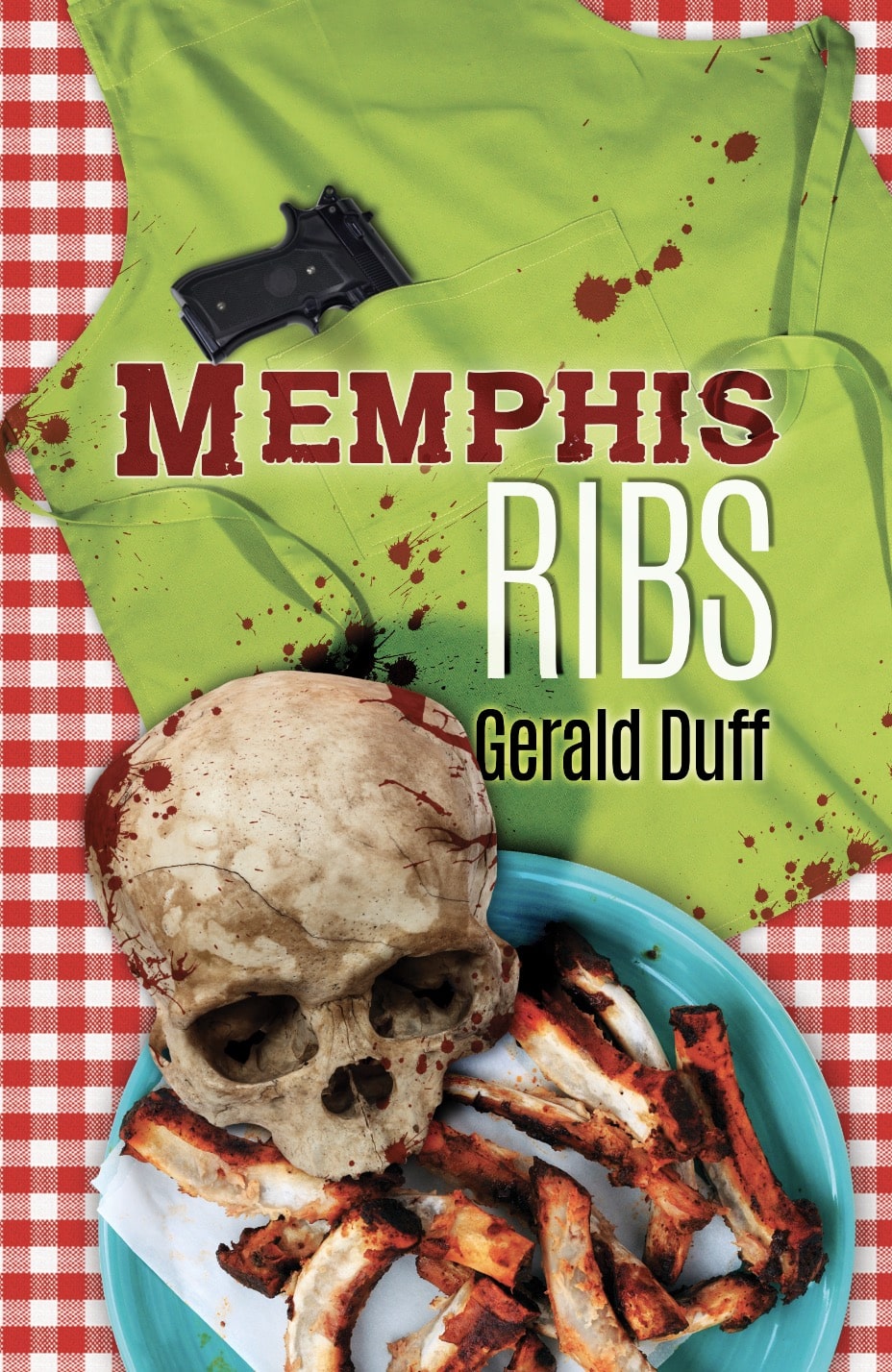

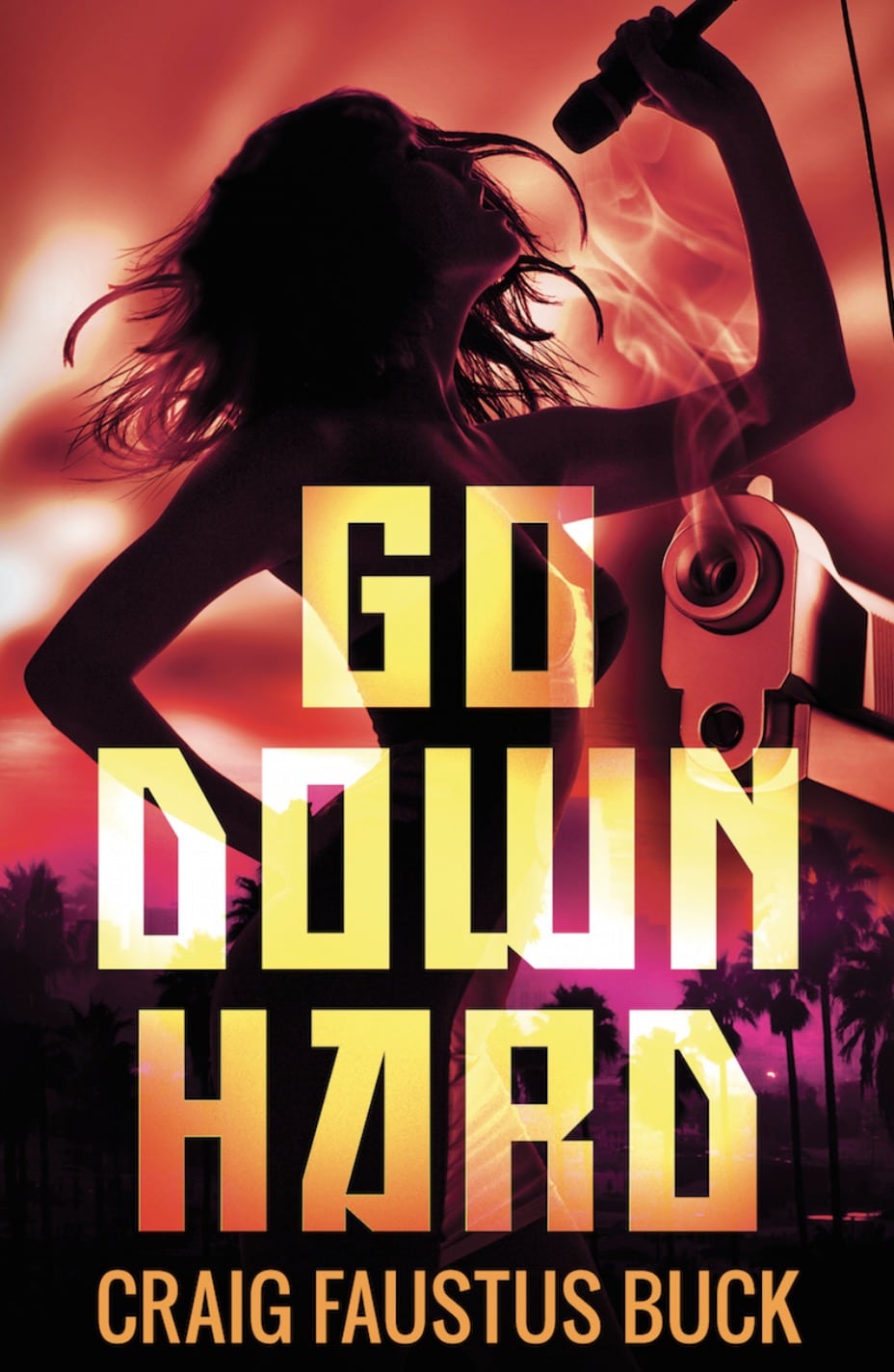

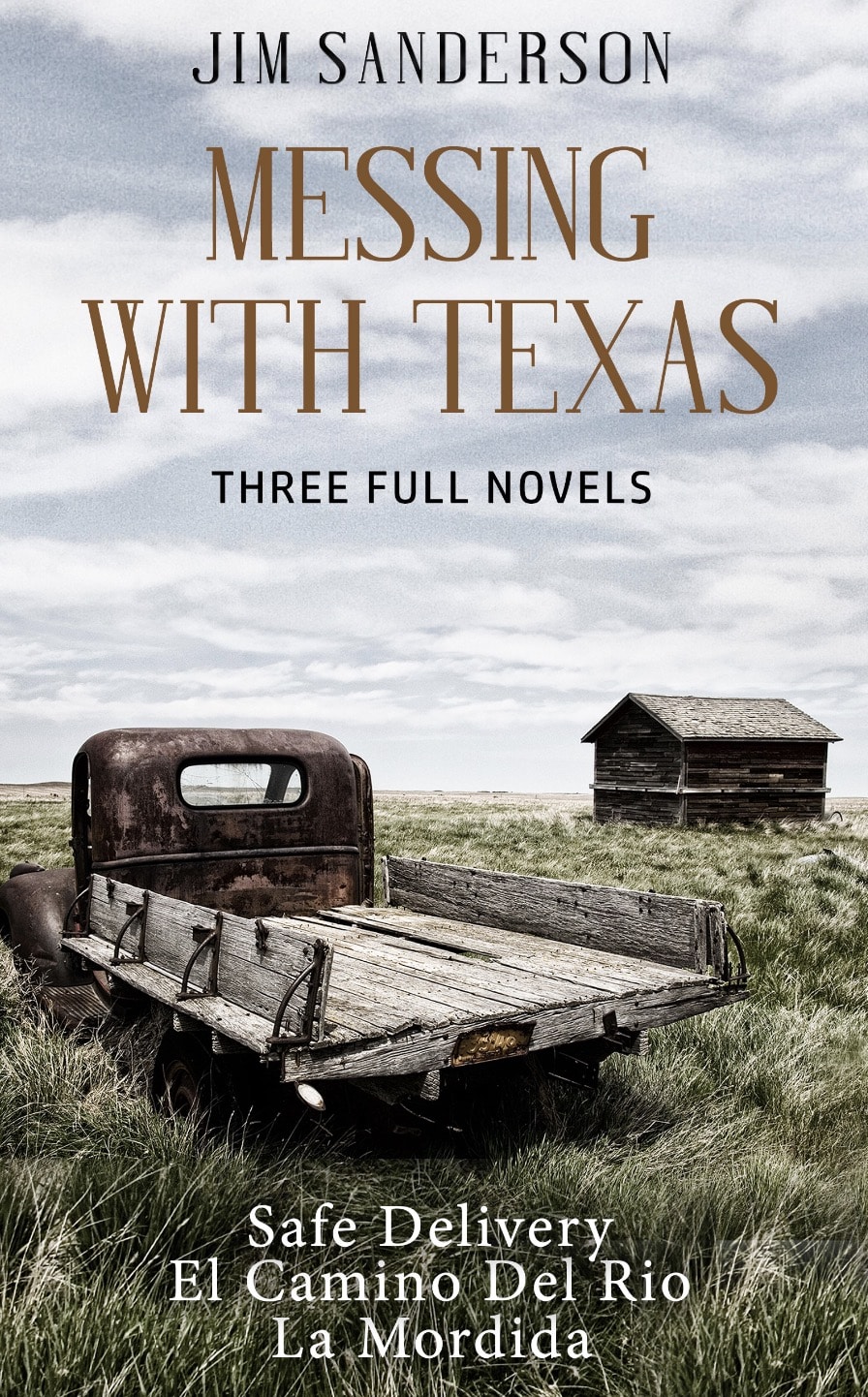

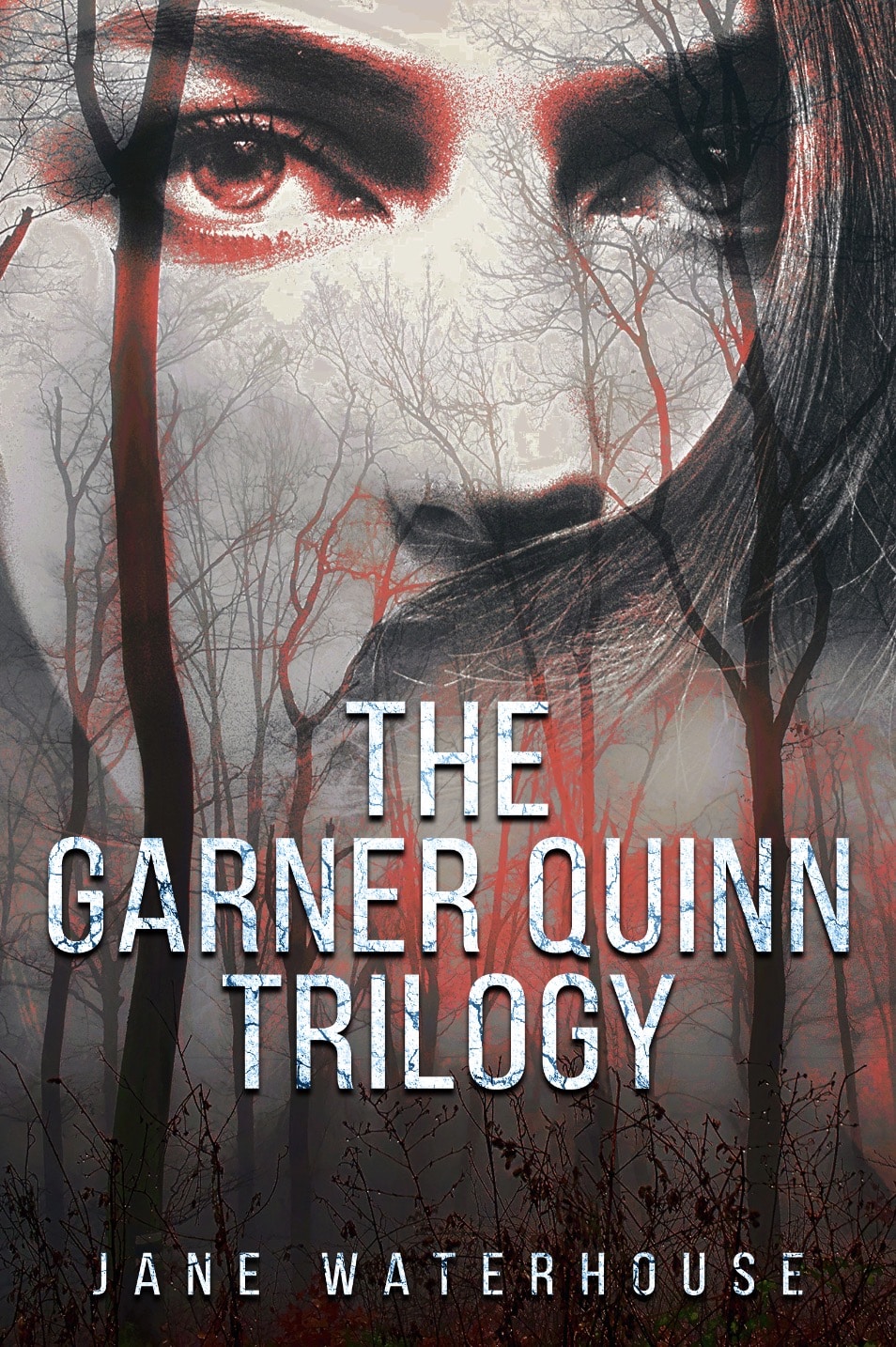

Das entspricht ziemlich exakt dem, was wir haben wollen. Und mir kommt eine Idee. Ich bin ja seit einigen Jahren mit Lee Goldberg befreundet, der mittlerweile die treibende Kraft hinter dem sehr erfolgreichen Krimi-Verlag/Netzwerk BRASH BOOKS ist. Deren Cover werden von Profis gestaltet und sehen u.a. so aus:

Sowas will ich auch! Also fix rüber zu PosterMyWall, Vorlage ausgesucht, Artwork hochgeladen und angepasst:

Ich muss das vielleicht noch mal deutlich sagen: für dieses Pulp-Krimi-Cover, das in dieser Form absolut vermarktungstauglich ist, habe ich keine zwei Minuten gebraucht. Kosten: 0 Euro.

Vielleicht ist auch das der Grund, warum es immer mehr Klautor:innen gibt – weil das ganze Drumherum eines Buches (Gestaltung, Druck, Vermarktung) immer einfacher und billiger wird und man den tatsächlichen Inhalt nur als etwas sieht, das man dann “auch noch irgendwie” besorgen muss. Als wäre der Roman nicht der Kern des Buches, sondern nur eines der vielen beliebigen Puzzleteile.

Aber ich schweife ab.

Beim Versuch, ein Krimi-Cover zu gestalten, zeigen sich noch mal deutlich die aktuellen Limitationen von MidJourney: Worte wie “Blut” und “blutig” lässt die KI nicht durch und der Versuch, eine aus dem Lauf blutende Pistole auf einem Tisch in einem schwach erleuchteten Büro zu generieren, führt zu desaströsen Ergebnissen – im Gegensatz zu einem Grafiker hat MidJourney keine Ahnung, was gemeint ist. Die KI versagt schon am Versuch, eine Pistole darzustellen:

Es lässt sich nicht bestreiten, dass die KI keinen Grafiker ersetzt, mit dem man Rücksprache halten kann, der statt Stichwörtern auch Intentionen versteht und dem man die Idee “hinter” dem Bild verständlich machen kann.

Aber das ändert nichts daran, dass MidJourney ein gänzlich neue Möglichkeit ist, Ideen zu visualisieren. Man braucht nur noch die Phantasie – nicht mehr die Beherrschung der Werkzeuge. The sky is the limit – or is it?

Um ausgerechnet EIN KAKTUS IST KEIN LUTSCHBONBON zu zitieren:

“Perfektion? Was ist das schon? Reaktionär-faschistoider Auswuchs von sturem Fleiß und Talent. Kunst ist Politik und das heißt: Gleichschaltung der Mindertauglichen mit denen, die bestimmen, was Kunst ist.”

Natürlich ist die Arbeit in einem Discord-Channel mit einer Command-Zeile nicht sehr komfortabel. Ich vermute, es ist nur noch eine Frage der Zeit, bis das in eine eigene App oder wenigstens in ein übersichtlicheres Web-Interface ausgelagert wird. Ich vermisse auch ein paar Funktionen: man sollte im Nachhinein einzelne Stichwörter anpassen können, ohne gleich eine komplett neue KI-Abfrage starten zu müssen. Es wäre auch ideal, wenn man Stichworte gewichten könnte, um die Verteilung nicht ganz der KI zu überlassen. Und schließlich: idealerweise sollte es möglich sein, bestimmte Elemente hochzuladen (eine existierende Figur, ein Logo, ein Schriftzug), um sie nahtlos in die Artwork zu integrieren.

Neben MidJourney ist in den letzten Monaten auch sehr viel über DALL.E 2 berichtet worden, aber damit habe ich mich schlicht noch nicht ausreichend auseinander gesetzt. Dieses Video gibt aber einen guten Einstieg in das Thema und zeigt gelungene Beispiele der Fähigkeiten des Algos:

Damit haben wir geklärt, WAS die neue Grafik-KI kann. Aber wie sieht es mit den Auswirkungen aus? Sitzen Grafiker demnächst mit dem Hut in der Fußgängerzone und betteln um Almosen? Wird die KI einen ganzen Berufszweig ersetzen? Wird sie interaktiv ein Gespräch simulieren können, in dem der User seine Wünsche präzisiert? Ist das eine schöne neue Welt oder ein Alptraum?

Die Antwort liegt wie immer (vermutlich) in der Mitte. So beeindruckend die Grafiken von MidJourney sind, wenn man sie außerhalb eines Kontexts sieht, so schwer tut sich die KI immer noch, exakt das zu treffen, was der User braucht. Das kann aber auch von Vorteil sein, denn die Vorschläge von MidJourney enthalten damit auch das Potenzial für Variationen und bis dato ungedachte Alternativen.

Profis und Firmen werden für die nächsten Jahre sicher nicht darauf verzichten wollen, ihre Produkte ebenfalls von Profis und Firmen gestalten zu lassen.

Aber das ist nur ein Aufschub und wenn man die Entwicklung der KI-Kreativität der letzten zehn Jahre betrachtet, mag man sich kaum vorstellen, wo wir in weiteren zehn Jahren sein werden. Ein gutes Beispiel ist die Serie STAR TREK: DISCOVERY, die ja bereits heute von KI-Bots geschrieben wird, die man mit Technobabble und Neusprech trainiert hat, denen aber jedes menschliche Verständnis für Figuren, Storys oder plausible Interaktionen abgeht. Es ist noch ein weiter Weg.

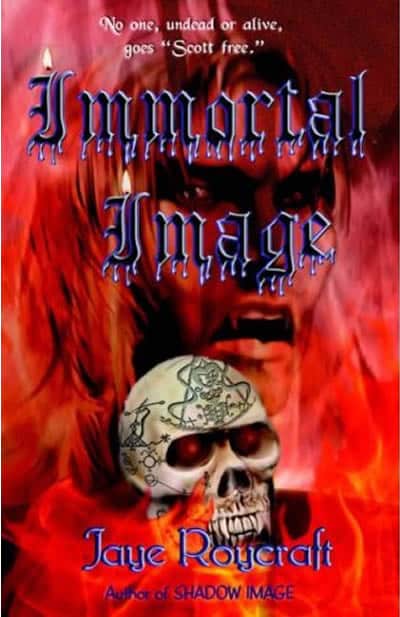

Ein Bereich, in dem Algos wie MidJourney heute schon massiven Einfluss nehmen können, sind die Low Budgtet-Produktionen, die sich bisher keine guten Grafiker leisten konnten, seien es Verlage, Filmfirmen oder Spielehersteller. Sie sind in der Lage, mit der KI zumindest den visuellen Auftritt ihres Angebots zu professionalisieren. So etwas muss nicht mehr sein:

Dabei ist die Artwork ist nur eine der vielen Seiten, auf der die KI aktuell die Kreativen der Welt angreift. Komponisten, Schauspieler, Autoren, Übersetzer – sie alle haben keinen Grund, sich in ihre Sessel zurück zu lehnen und zu denken “bin ich froh, dass ich kein Grafiker geworden bin”. You are not safe.

Aber das ist ein Thema für einen anderen Tag.

Und damit übergebe ich wie immer an euch. Wie seht ihr das? Kribbelt es euch in den Fingern, auch mal mit MidJourney zu spielen? Ist das ein Trend wie Tamagotchis, über den in zwei Jahren keiner mehr spricht? Oder ist es nur die Spitze des Eisbergs von Umwälzungen, in derem Rahmen die Technik mittelfristig nach der körperlichen Arbeit auch die kreative ersetzt?

Sehr cool, dass du das aufgreifst. Hatte schon paar mal überlegt, dich darauf hinzuweisen – war einer von denen, die von Wombo bzw. den Aussichten, das praktisch zu nutzen, damals noch nicht so angetan waren. Dalle und vor allem Midjourney haben mich geflasht – obwohl ich in diesen KI-Sachen eigentlich up-to-date bin und das Prinzip der exponentiellen Entwicklung verinnerhalt zu haben glaubte.

Midjourney liefert schon jetzt atemberaubende Ergebnisse im Sekundentakt. Und auch, wenn man meist nicht exakt das bekommt, das man sich vorgestellt hat und gezielte Revisionen nicht möglich sind, ist der Nutzen schon enorm. Hab in meiner Freizeit immer mal an Rollenspielbüchern herumgeschrieben, was fehlte waren Illustrationen. Die beauftragt man nicht, wenn das Werk eher in der Schublade verschlummern wird. Mit Midjourney lässt sich das machen. Landschaften, Figurenportraits, Kreaturen, … gar kein Problem. Und wenn sie ein bisschen anders aussehen als gedacht, who cares .. Midjourney beflügelt mit seinem Detailgrad eher noch die Fantasie.

Das ist also schon jetzt Konkurrenz für professionelle Zeichner. Wenn die Features weiter ausgebaut werden (Dalle2 kann ja schon gezielte Änderungen, indem man nur bestimmte Bildteile markiert und bearbeiten lässt – das liefert mir aber bislang keine überzeugenden Ergebnisse), sehe ich den Kob des Illustratoren ernsthaft in Gefahr. Und wir reden hier von einem Zeitraum von 1 bis 2 Jahren, in denen ich das erwarte.

Für (Stock) Photographie gilt dasselbe – Dalle kann ziemlich fotorealistisch.

Andere Jobs werden folgen. Ich hab immer gesagt, als Programmierer und Grafiker bin ich der letzte, den das betrifft, denn beides kann KI nicht. Würde ich heute so nicht mehr sagen.

Finde das sehr spannend, als Illustrator bin ich erstaunt über die guten Ergebnisse. Kann gut verstehen, wenn das zukünftig genutzt wird für Illustrationen. Wenn möglich, würde ich das sogar auch nutzen wollen – ich würde dann Bildelemente erstellen lassen, die ich dann kombinieren könnte. Zum Beispiel ein toller Hintergrund, den ich nicht selber malen muss, so dass ich mich auf die Figuren im Vordergrund konzentrieren kann, die ich dann dazu male. Ich würd’s auf jeden Fall mal versuchen.

Ich spiele mich seit ein paar Wochen mit Midjourney und bin total fasziniert. Bis jetzt habe ich mich hauptsächlich mit der Darstellung von Portraits von realen Personen und fiktiven Charakteren beschäftigt. Diese von der KI in unterschiedlichen Art-Styles und Zeichenstilen berechnen zu lassen, lässt mich immer wieder in Verzückung geraten. Erstaunlich auch, wie gut Midjourney den Stil anderer Künstler imitieren kann. Sylvester Stallone von Ralph Steadman gezeichnet? Pinhead von H. R. Giger? Der Joker im Stil von Edvard Munch? Wie wäre Harley Quinn von Picasso auf die Leinwand gebannt worden? Ein Batman von Bansky? Alles kein Problem.

Gewichten kann man (Text Weights), ich habe mich bis jetzt aber noch kaum mit dieser Funktion beschäftigt. Jedenfalls beträgt die Standard-Gewichtung 1 und mit einem Suffix kannst Du diese Gewichtung vermindern oder erhöhen. Vergleiche z.B. mal die Ergebnisse für die folgenden Beispiele:

michael jackson :: alien

michael jackson::0.5 alien::1.5

Danke für die Tipps – sehr spannend!

Immer wieder interessant, was du so alles ausgräbst und ins Bewusstsein rückst!

Das die Bilder aus dem Showcase tatsächlich 100% generiert wurden, mag man kaum glauben. Das muss erst mal sacken.

Hinsichtlich “Algorithmus”: In seiner ursprünglichen Bedeutung mehr oder minder “Rechenvorschrift”, ist das hier – auch wenn in den Medien davon oft die Rede ist – vielleicht nicht der 100% richtige Ausdruck. Ich würde eher von “Modell” sprechen, genauer gesagt einem “Maschienenlernmodell”. Die dahinterstehenden Algorithmen sind natürlich wichtig, aber mindestens ebenso wichtig sind die Daten, die zum Trainieren verwendet werden, sprich Bilder und dazugehörende Bildbeschreibungen. Obendrein suggeriert “Algorithmus” in meinen Augen, daß man genau weiß, was da passiert. Was bei Maschienenlernen aber nicht wirklich der Fall ist – ethische Fragen hinsichtlich der Zusammensetzung der Trainingsdaten sind ein heißer Diskussionsstoff.

Hier hatte z.B. auch (galube) Merkel mMn recht, als sie Daten das Gold der Zukunft nannte.

“Komponisten, Schauspieler, Autoren, Übersetzer – sie alle haben keinen Grund, sich in ihre Sessel zurück zu lehnen und zu denken “bin ich froh, dass ich kein Grafiker geworden bin”. You are not safe.”

Automatische Übersetzungen sind für gewisse Sprachkombinationen schon richtig gut, aber nicht perfekt. Quasi als Vorlage, die ein Übersetzer korrigiert, kann ich mir das aber gut vorstellen (wenn das nicht schon gemacht wird).

In Sachen “Churnalismus” (Presseaussendungen von Firmen, der Polizei, Agenmturmeldugen etc zu einem Artikel ohne eigene Recherchetätigkeit zu verwursten) ebenso. Komplette Bücher aus der KI? In näherer Zukunft nicht denkunmöglich. Aber auch hier wird es wohl Feinarbeit brauchen, um die aufzuputzen. Schauspieler? Mittelfristig wird Deepfaking ein großes Thema in der Schauspielbranche werden. Ich halte es nicht für unmöglich, daß man sich dann seinen persönlichen Traumcast bei der neuesten Netflix-Serie live reinrendern lassen kann. Voice Acting wird wohl auch betroffen sein. Oder um auf Bücher zurückzukommen – Audiobücher kann man sich bei Google Play schon jetzt automatisch erstellen lassen.

Generell würde ich sagen – mittelmäßig bis schlechte Resultate wird eine KI alleine erzeugen können, gute Resultate KI+menschliche Qualitätskontrolle, für Top Resultate sehe ich die KI (derzeit) maximal als Inspiration.

Im Endeffekt wird es in diesem Bereich zu einer Produktivitätssteigerung kommen und ein Teil der Jobs verloren gehen.

Hm, also ich halte “Algorithmus” nach wie vor für den richtigen Begriff.

Ein Algorithmus ist, wie du richtig sagst, eine Rechenvorschrift bzw. eine Prozessvorschrift für einen Transformationsprozess: Eingehende Daten werden in ausgehende Daten transformiert; noch richtiger: Eingehende Daten werden verwendet, um ausgehende Daten zu errechnen (eine reine Transformierung könnte suggerieren, dass die eingehenden Daten in ihrer Form nicht mehr existieren, weil sie ja “weg”transformiert wurden). Genau das passiert bei klassischen Machine Learning-Ansätzen: Es gibt eine Reihe von Algorithmen, die eine Transformation abbilden, also die Prozessvorschrift. Diese Algorithmen werden genutzt, um eingehende (oder bereits existierende) Daten einzulesen und daraus die Ausgabedaten zu errechnen. “Machine Learning” unterscheidet sich nicht grundlegend von früheren Herangehensweisen, mit der Ausnahme der Menge der verfügbaren Eingangsdaten und sicherlich fortgeschrittener Formen von Algorithmen, die mit den Mengen klar kommen müssen (“Map-Reduce” bspw. war mal der neue heiße Scheiß vor 15 Jahren, aber am Ende war es nur ein simpler Code, ein Algorithmus). Heute können Rechencluster halt mit Abermillionen Bildern umgehen, diese analysieren, ihre jeweiligen “Tags” lesen und so der Eingabe des Menschen einen scheinbaren Sinn verleihen.

Beispiel: In meiner Datenbank finden sich vier Bilder: Ein Bild mit einem Hund, als “Hund” getaggt, gleiches mit einer Katze, und dazu noch zwei einfarbige Bilder, jeweils passend mit “grün” und “blau” beschriftet. Mensch gibt ein: Hund vor blauem Himmel. Dann kommt der Algorithmus, liest das Wort “Hund” und “blau” aus der Eingabe und sucht passend benannte Bilder oder fährt bspw. eine klassische Farbanalyse, um eine Farbe zu erkennen. Dann wird vom Hundebild noch ein zentrales Objekt gefunden und mithilfe normaler Zeichenwerkzeuge, wie “Freistellen” extrahiert und auf das vermutlich blaue Bild geklatscht. Fertig. Alles kein Hexenwerk, klassische Algorithmik. Die Magie besteht lediglich in der schieren Masse der zur Verfügung stehenden Daten und der sicherlich deutlich ausgefeilteren Algorithmen. Aber es bleiben Algorithmen. Sehr deterministisch.

Sind die Menschen glücklich, wird das generierte Ergebnis gespeichert, und vielleicht sogar mit der Eingabe des Menschen getaggt und damit um Semantik, also einer inhaltlichen Bedeutung, erweitert und so hat der Algorithmus im nächsten Schritt ein Bild mehr zur Verfügung. Das ist dieser selbst”lernende” Schritt in “Machine Learning”.

Dass Machine Learning heute als “Magie”, als nichtdeterministisch, als nicht mehr nachvollziehbar gilt, liegt einzig und allein nur daran, dass der Mensch nicht mehr in der Lage ist, diese unglaubliche Masse an Rechenschritten und Trainingsdaten selbst zu erfassen und damit nachzuvollziehen oder zu debuggen. Dennoch ist und bleibt es ein mehr oder weniger simpler Algorithmus, der da Anwendung findet. “Machine Learning” ist noch so weit von künstlicher “Intelligenz” weg, wie jede Algorithmik vorher. Die Computer sind nur besser in Prozentrechnung und Abwägung, welche Daten wohl am besten geeignet wären, um irgendeine Form von Antwort zu geben.

Ich will damit die Ergebnisse, wie bspw. die hier vorgestellte Anwendung, keineswegs klein reden. Es erfordert extrem viel Know-How, passende Algorithmen zu programmieren und passende Trainingsdaten auszuwählen. Ich will nur sagen: Am Ende ist alles immernoch deterministische Algorithmik.

Über den Begriff des “Modells” kann man sich hingegen sehr trefflich endlos lange streiten, glaube ich 😀

Ich finde die Entwicklung sehr interessant. Ich habe selbst als Concept Artist gearbeitet, allerdings damals noch weitestgehend “analog”, mit Stiften, Farbe und Pinsel. Als sich vor etwa 20 Jahren alles komplett auf die digitale Ebene verlagert hat, habe ich das Fach gewechselt. An der Arbeit mit dem Grafiktablett hatte ich nie so meine rechte Freude, aber das wurde schliesslich unerlässlich. Ich will jetzt nicht unbedingt die “Früher-war-alles-besser”-Leier auflegen, die Produktivität der Künstler hat sich durch die Technik ja wirklich ganz enorm erhöht. Gleichzeitig ging meiner Meinung nach aber auch eine gewisse Individualität der einzelnen Künstler verloren, weil letztlich jeder die gleichen Werkzeuge und ähnliche Stile benutzte. Nach wie vor gab und gibt es Künstler, die digital einzigartige und unverwechselbare Werke erschaffen, aber es existiert auch eine grosse Masse zwar qualititativ hochwertiger, aber nicht wirklich stilistisch individueller Bilder. Klar war das im Analogen auch immer der Fall, aber durch die Digitalisierung wurde alles viel einfacher, schneller und weiter verbreitet. Ich nehme an, die AI bedient sich nun zu einem grossen Teil aus diesem gigantischen Pool und die Ergebnisse werden von Mal zu Mal beeidruckender. Ich bin jedenfalls froh, daß ich mit sowas nicht mehr beruflich konkurrieren muss, als reine “Gebrauchskunst” wird das immer mehr zur validen Alternative. Meine persönlichen künstlerischen Ambitionen verwirkliche ich nach wie vor auf die gute alte “analoge” Weise – praktischerweise hat man dadurch auch nur ein echtes, physisches Original und braucht keinen Unsinn wie NFTs. Das wird auch weiter seinen Platz haben – ebenso, wie qualitativ und künstlerisch hochwertige, menschengemachte digitale Kunst. Die Malerei wurde ja auch nicht völlig eingestellt, als die Fotografie aufkam.

Hier noch ein Kandidat

https://netzpolitik.org/2022/text-zu-bild-generierung-der-anfang-von-etwas-grossem/

Sowas ersetzt natürlich nicht den Grafiker. Aber es hilft Leuten wie mir doch schon massiv mit Grafikern zu kommunizieren. Immerhin kann man mit der Software die Zielvorgabe machen und das dann in schön und Detailverbesserungen zusammenschustern lassen. Das drückt die Kosten nochmal, aber damit kann der Grafiker ja auch viel schneller arbeiten. Wie oft kommt es vor, dass man sich nicht klar ausgedrückt hat und man dann doch eher was komplett falsches vorgesetzt bekommt.

So kann ich die Vorgabe machen und der Grafiker kann sich besser orientieren. Man kann ja auch diskutieren, ob man dem Grafiker mehr Freiraum lässt, aber zumindest die Grundstimmung sehr klar.

Der Geisterbahn kann man für einen Groschenroman durchwinken, aber sonst ists doch arg unsauber.

Rule34 wurde doch vermutlich aus zwei Gründen großzügig verboten: Weil man dafür Kohle verlangen kann und weil das vermutlich auch arg zweifelhafte Bilder (Freakshow!) erzeugen würde.

Passend hierzu: https://youtu.be/3YNku5FKWjw

Beeindruckend. Aber noch sind die Bilder irritierend wegen inhaltlichen Fehlern im Detail.

Die KI wird mit den Werken von Künstlern und Markeninhabern gefüttert. Versteht sogar „im Stil von H. R. Giger“ berichtete hier ein Kommentator.

Dürfen die Macher des Angebotes das? ist eine Frage die spätestens dann heiß diskutiert wird wenn der KI-Geist aus der Flasche einem einfach einen neuen Batman-, Star Wars oder Marvelfilm generieren kann.

Hoffentlich zerstören KI-Texte nicht Suchergebnisse, also dass man nur noch von KIs massenhafte SEO-optimierte Websites findet.

Große politische Gefahr wenn Russland und andere keine menschlichen Trolle mehr beschäftigen müssen sondern KIs massenhaft Falschinformationen in den sozialen Medien verbreiten.

Sogar Wettbewerbe werden damit gewonnen.

Wobei hier der Mensch noch nachbearbeitet hat.

https://www.heise.de/news/Tod-der-Kunst-Von-KI-generiertes-Bild-gewinnt-Kunstwettbewerb-in-den-USA-7250847.html

Der Text ist ja fast schon wieder veraltet. Inzwischen kann man sich mit “Stable Diffusion” eine Bilderzeugungs-AI auf den heimischen Rechner holen. Eine halbwegs aktuelle Grafikkarte mit viel RAM vorausgesetzt, lassen sich damit nicht nur Texte in Bilder verwandeln, sondern auch selbst gefertigte Skizzen. Somit kann man nun auch den Inhalt des Bildes genauer steuern. Bis der Normalbürger die 12GB-Grafikkarte im PC hat, dauert es sicherlich noch ein paar Jahre, aber wenn ich Zeichner wäre, würde ich schon mal über eine Umschulung nachdenken.

Die Entwicklung ist aktuell wirklich rasant:

https://t3n.de/news/bilder-ki-dall-e-outpainting-1496174/

[…] rudimentären Ansätzen wie bei Wombo bis zu komplexen “text to picture”-Systemen wie MidJourney. Die Ergebnisse faszinieren, sind aber momentan noch mehr Experiment als Ersatz für echtes […]

Ich als Fotograf habe keine Angst durch die KI´s verdrängt zu werden. Ich finde die Kombination sehr spannend und freue mich über die Entwicklung.

Das freut mich zu hören. Die meisten Fotografen, mit denen ich spreche, sind da eher knarzig.

Nur 1664 x 1664…

Ein Bild in 4K oder besser wäre gut als Hintergrund für Videos.

Auf Quora hat einer “schönes Herrenzimmer” verlangt.

Vorher Chat-GPT gebeten das zu beschreiben, und die Beschreibung verwendet.

Ein paar Gedanken…

Ein möglicher Hintergrund wäre z.B. das Herrenzimmer wie eine Late-Night-Show mit Schreibtisch (im passenden Stil), links im Bild Platz für Sessel oder Sofa daneben. Also nur der Platz, nicht die Sitzmöbel.

Dahinter Fenster mit z.B. Kölner Ansicht inkl. Dom. Aber ohne Alk und Tabak (war Teil des Beispiel auf Quora).

Keine Ahnung ob sich Late-Night überhaupt mit Herrenzimmer inkl. der Bücherwand kombinieren ließe.

Das Fenster nimmt ja Fläche für das Ambiente wie Bücherwand.

Hinter der Gast-Fläche wäre Platz, wenn das Fenster nur den Schreibtisch abdeckt..

Eine nutzbare Videofläche wäre auch interessant.

Fehlt noch die Möglichkeit eines “Moving Background”.

Z.B. wenn man ein Kaminfeuer haben will.

Oder Leben hinter dem Fenster.

Wind in Bäumen, Flugzeuge, Vögel etc..

Oder sogar so ein Fenster wie in manchen Sendungen des ÖRR zur Straße mit großer Glaswand, wo man Passanten sieht…

Midjourney kostet Geld, oder?

Werbevideos etc. sehen wäre eine schöne Option. Mittlerweile fährt man in Düsseldorf so sogar Bus/Bahn.

Ich erinnere mich an einen Link zu einem Discord-Kanal, wo auf einmal die Kostenpflichtigkeit erwähnt wird.

Auch wenn es 25 freie gäbe, da würde man sich genau überlegen, worum man bittet.

Und die Frage einige Tage lang möglichst exakt formulieren…

So dass es bis zum Lebensende reicht 😉 .

Craiyon ist eher ein Gag was die Qualität angeht. Sie aus wie Street-View 3D auf Straßenebene.

Und bei Dream ai sieht es auf den ersten Blick kostenlos aus, aber 3 von 4 Bildern sind wohl nur mit Zahlung zugänglich.

Habe auch nicht getestet ob es eine IP-Grenze gibt.

Und es sind maximal 200 Zeichen.

Keine Ahnung welche KI der genutzt hat, aber gerade hat irgendeiner dieser Stand-Alone-Journalisten (Reichelt, Poschardt und Co.) ein “Foto” von diesem Beleidigungs-Troll Sebastian Pertsch genutzt, wo dieser 5 Finger PLUS Daumen hat.

Ich kann verstehen wenn man sich mangels CC-Foto ein Bild erstellen lässt, aber Ich habe über Google ein CC-Bild gefunden.

Schön wäre auch eine KI in die Ich z.B. ein Foto einer Deckenlampe hochlade, evtl. aus mehreren Perspektiven, und sie findet auf Ebay, Ebay Kleinanzeigen etc. gleiche oder ähnliche Leuchten.

Auch als Suchauftrag.

Die Bing-Fotosuche kann das nicht.

Ich kommentiere das einfach mal hier stellvertretend, weil mir der Beitrag in Erinnerung geblieben ist: Magst du deinen AI-Beiträgen einen eigenen tag spendieren, der etwas aussagekräftiger ist als “Neues”? Dann könnte man die direkt über die Themenliste links finden. Musste länger wühlen, um hier wieder herzufinden 🙂 Sind doch mittlerweile einige schöne zusammengekommen..